Z Gniewoszem Leliwą, CTO i współzałożycielem Samurai Labs, rozmawiamy na temat bezpieczeństwa w sieci zwłaszcza w kontekście jednostki i jej tożsamości. Firma zapewnia nowoczesne metody detekcji i aktywnie przyczynia się do redukcji cyberprzemocy, a także wykrywa i wspiera osoby w kryzysie samobójczym — projekt One Life. Samurai wykorzystuje sztuczną inteligencję nowej generacji – technologię opartą na uczeniu maszynowym, która jest połączona ze skutecznym wnioskowaniem.

Grzegorz Kubera, Vault-Tech.pl: Jakie konkretne technologie i algorytmy wykorzystuje Samurai Labs do detekcji i prewencji cyberprzemocy?

Gniewosz Leliwa: Nasze modele tworzymy w nurcie neuro-symbolicznej sztucznej inteligencji, łącząc najnowsze osiągnięcia z dziedziny uczenia maszynowego z symbolicznym wnioskowaniem w oparciu o wiedzę ekspertów. Udało nam się wypracować i opatentować bardzo efektywny sposób łączenia tych dwóch, pozornie przeciwstawnych podejść, co pozwala na wykrywanie rzadkich i niebezpiecznych zjawisk z precyzją, umożliwiającą działanie proaktywne, a nie jak do tej pory – reaktywne.

Jednym z podstawowych zadań części symbolicznej jest zarządzanie częścią statystyczną, żeby nie narobiła głupot, jak to czasem ma w zwyczaju robić. Poza tym, wykorzystując wiedzę ekspertów, np. suicydologów czy psychologów, oraz głęboką wiedzę lingwistyczną, „objaśniamy” naszym modelom, które treści są obraźliwe i dlaczego, oraz w jaki sposób komunikują się osoby w kryzysie samobójczym. Nadal korzystamy z danych oznaczanych przez ludzkich ekspertów, ale podejście hybrydowe pozwala nam bardzo efektywnie wykorzystywać te dane, przez co potrzebujemy ich znacznie mniej. Co więcej, nasze modele są w stanie wykrywać przypadki, które nigdy wcześniej nie pojawiły się w zbiorach uczących.

Jeśli chodzi o duże modele językowe, czy też szerzej – część statystyczną, to z jednej strony pomagają nam wykrywać i klasyfikować te wszystkie niebezpieczne treści, a z drugiej pozwalają zrozumieć szerszy kontekst poszczególnych wypowiedzi, dodatkowo redukując wyniki fałszywie pozytywne. Co do technologii, to oczywiście Transformery i maskowane modele językowe, takie jak BERT czy RoBERTa. Modele generatywne, choć bardzo potężne, służą nam przede do testów i ulepszania modeli neuro-symbolicznych. Niemniej, bacznie śledzimy ich rozwój i mocno kibicujemy.

Jakie są główne różnice pomiędzy Waszym podejściem a tradycyjnymi metodami moderacji opartymi na filtrach i słowach kluczowych?

Przede wszystkim takie, że nasze modele bardzo dobrze „rozumieją” kontekst i przeróżne niuanse językowe, których nie mają szans „zrozumieć” metody oparte o filtry czy słowa kluczowe. Podczas gdy tradycyjne metody potrafią wykryć słowo „samobójstwo” czy frazę „chcę się zabić”, nasze modele wykrywają i rozróżniają myśli samobójcze, deklaracje świadczące o zamiarach podjęcia próby samobójczej, a nawet opisy konkretnego planu lub metody.

Wykrywają też inne sygnały, takie jak informacje o poprzednich próbach samobójczych czy pożegnania z rodziną, przyjaciółmi lub członkami danej społeczności, które pełnią bardzo istotną rolę w procesie oceny ryzyka i stosowania adekwatnej do stadium kryzysu interwencji.

Potrafimy odróżnić pikantne rozmowy o seksie na portalach randkowych od seksizmu i nękania na tle seksualnym. To tylko przykład, ale świetnie obrazuje, jak dokładnie samo słownictwo może być użyte w bardzo różnych scenariuszach. Tradycyjne metody nie są w stanie dokonać takiego rozróżnienia. Co więcej, często nie radzą sobie z tym również modele uczenia maszynowego. A przynajmniej nie potrafią robić tego na tyle precyzyjnie, aby umożliwić automatyczną reakcję.

W jaki sposób Samurai Labs osiąga tak niski wskaźnik fałszywych alarmów (false positives) w porównaniu do konkurencji?

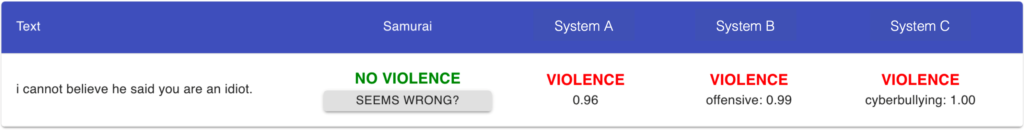

To właśnie zasługa podejścia neuro-symbolicznego. Proszę wyobrazić sobie, że mamy sklasyfikować zdanie: „nie mogę uwierzyć, że powiedział, że jesteś idiotą”. Modele konkurencji, oparte wyłącznie o uczenie maszynowe, skupią się na części „jesteś idiotą” i uznają wypowiedź za ofensywną.

Nasze modele, dzięki zarządczej funkcji modułów symbolicznych, wykryją mowę zależną i ocenią, że potencjalnie obraźliwa treść jest tylko częścią przytaczanej wypowiedzi, a zatem sama w sobie nie jest ofensywna.

Dokładnie ten przykład, po angielsku, wraz z reakcją trzech konkurencyjnych rozwiązań, widać na zamieszczonym zrzucie ekranowym:

Czy może Pan opisać proces integracji Waszych narzędzi moderacyjnych z istniejącymi platformami?

Podzielmy odpowiedź na dwie części – jedną związaną z cyberprzemocą, a drugą z samobójstwami i samookaleczeniami (SSH, z angielskiego „Suicide and Self-Harm”).

Zacznę od SSH. Tu naszą główną propozycją jest kompleksowe rozwiązanie problemu na danej platformie – monitorujemy cały ruch, sztuczna inteligencja wykrywa potencjalne zagrożenia, a nasi eksperci, suicydolodzy i psycholodzy, interweniują i reagują w przypadku nawiązania bezpośredniego kontaktu. Wykrywamy i reagujemy nie tylko w przypadku ideacji samobójczych, ale również zachęcania czy namawiania do popełnienia samobójstwa lub samookaleczania się.

Alternatywą jest „gołe” API lub opracowanie tzw. SSH Risk Assessment platformy, na podstawie dostarczonych nam danych historycznych.

Jeśli chodzi o cyberprzemoc, to jedną z opcji jest autonomiczny moderator – API, które służy do sterowania botem moderacyjnym na danej platformie lub w grze online. Taki bot czyta wszystkie wiadomości i reaguje zgodnie z konfiguracją, którą definiuje się w dedykowanym panelu konfiguracyjnym. Można też wybrać któryś z gotowych presetów, np. dla społeczności „family-friendly” lub „tylko dla dorosłych”.

W przypadku niektórych platform, takich jak Twitch czy Discord, oferujemy gotowego bota moderacyjnego, którego wystarczy zaprosić na swój stream czy serwer i skonfigurować.

Alternatywą, podobnie jak w przypadku SSH, jest tu „gołe” API, które oferujemy firmom świadczącym usługi BPO, czyli Business Process Outsourcing.

Jakie korzyści płyną z pełnej automatyzacji moderacji w porównaniu do wspomagania istniejących zespołów moderatorów przez AI?

Przede wszystkim czas reakcji, który pozwala na zmianę paradygmatu – z reaktywnego na proaktywny. Dzięki automatyzacji możemy reagować zanim ktokolwiek przeczyta wiadomość, czyli zanim wydarzy się krzywda. Ofiara cybernękania nie musi doświadczyć ataków ze strony swoich oprawców, a następnie zgłosić tych treści, licząc na ukaranie agresora. Te wiadomości mogą zostać zablokowane, zanim w ogóle do niej dotrą. W przypadku samobójstw i samookaleczania się, szybkość reakcji może zaś zadecydować o ludzkim życiu lub zdrowiu.

Inną korzyścią jest znaczne zmniejszenie ekspozycji zespołów moderacyjnych na treści, których nikt nie chce i nie powinien oglądać. I mówimy tu nie tylko o wypaleniu zawodowym, ale również o symptomach stresu pourazowego (PTSD), z którymi nierzadko mierzą się moderatorzy treści na popularnych platformach.

Czy może Pan podać konkretne przykłady zastosowań Waszych produktów w rzeczywistych scenariuszach?

W ubiegłym roku wykonaliśmy ponad 25 tysięcy interwencji na platformie Reddit. Chodziło o wykrywanie i reagowanie na różne formy ideacji samobójczych. Od 9,5% do 15,1% osób, które otrzymało nasze interwencje, skorzystało ze specjalnych linii, gdzie otrzymało profesjonalną pomoc. 8% skorzystało z materiałów samopomocowych, przygotowanych przez ekspertów-suicydologów, a ponad 5% skontaktowało się bezpośrednio z naszym zespołem.

Jeśli chodzi o moderację cyberprzemocy, to w grudniu 2023 monitowaliśmy kilka bardzo dużych turniejów e-sportowych, gdzie osiągnęliśmy świetne wyniki w porównaniu z całym zespołem moderacyjnym, wspieranym przez narzędzia AI. Na każde 100 automatycznie wykrytych wiadomości, Samurai wykrywał kolejne 64, które wcześnie zostałyby przeoczone. Z kolei na każde 100 ręcznie moderowanych wiadomości, Samurai automatyzował 23, ze sporym potencjałem na więcej. Warto zaznaczyć, że turnieje esportowe należą do najtrudniejszych poletek do moderacji, bo komentarze bardzo często nawiązują do tego, co aktualnie dzieje się na ekranie, a modele detekcji nie mają o tym żadnej wiedzy.

Jak Samurai Labs radzi sobie z dynamicznie zmieniającym się krajobrazem zagrożeń online i regulacji prawnych?

Bardzo kibicujemy mądrym regulacjom prawnym, bo to one wymuszają na platformach zmianę podejścia z reaktywnego na proaktywne. Zwłaszcza brytyjski Online Safety Act robi tu dużo dobrego, zobowiązując platformy do zajęcia się na poważnie takimi tematami, jak samobójstwa i samookaleczenia.

Wcześniej platformy mogły stosować swojego rodzaju wytrych, twierdząc, że nie mogą odpowiadać za treści, o których istnieniu nie wiedzą. Teraz to się zmienia.

Na zmieniający się krajobraz zagrożeń online przygotowujemy się, przyjmując filozofię systemów antywirusowych. Nie da się opracować jednego modelu, który będzie działał zawsze i wszędzie. Dlatego stale analizujemy dostępne dane i rozwijamy nasze modele, udostępniając nowe wersje średnio raz na dwa tygodnie. Pracujemy też nad coraz lepszymi metodami zabezpieczania się przed obchodzeniem naszych metod detekcji, wliczając w to tzw. adversarial attacks, które w tekście mogą przejawiać się jako zamiana liter na podobnie wyglądające symbole, również z innych alfabetów, czy też celowe literówki i inne błędy.

Jakie są Wasze plany rozwoju na przyszłość, jeśli chodzi o technologie moderacyjne i ochronę użytkowników w internecie?

Chcemy w kompleksowy sposób zdejmować z platform problemy, których nie chcą, nie potrafią lub nie mogą rozwiązywać, jako firmy, które nie zajmują się zdrowiem psychicznym. Chcemy w mądry sposób łączyć sztuczną inteligencję z pracą ekspertów, którzy będą czuwali nad całym procesem i reagowali w sytuacjach zagrożenia. W szczególny sposób traktujemy tu temat samobójstw i samookaleczeń, ale nie zapominamy przy tym o cybernękaniu, które często bywa z nimi mocno związane, jako jedna z ich istotnych przyczyn.

Jeśli chodzi o technologię, to przede wszystkim chcemy obsługiwać nowe języki i nowe typy danych. Nowe, rewelacyjne modele ASR, takie jak Whisper od OpenAI, pozwalają nam na poważnie myśleć o analizie audio, czy to nagrań i filmów, czy moderacji gier online z komunikacją głosową.

Oczywiście priorytetem pozostaje dla nas rozwój modeli i metod prewencji w przypadku ideacji samobójczych oraz zachęcania i namawiania do samobójstw lub samookaleczania się.

— Rozmawiał Grzegorz Kubera