Z nowych badań mediów społecznościowych wynika, że aplikacje wykorzystujące sztuczną inteligencję do rozbierania ludzi na zdjęciach cieszą się coraz większą popularnością. Programy te manipulują istniejącymi zdjęciami i filmami przedstawiającymi prawdziwe osoby i sprawiają, że wyglądają na nagie. Dzieje się to oczywiście bez ich zgody, a często też wiedzy. Wiele z tych aplikacji do rozbierania działa tylko na zdjęciach kobiet.

W niedawnym badaniu przeprowadzonym przez firmę Graphika, zajmującą się analizą mediów społecznościowych, przeanalizowano 34 firmy oferujące usługę rozbierania ludzi ze zdjęć. Graphika określa ją „intymnymi obrazami wykonywanymi bez zgody” (non-consensual intimate imagery – NCII). Eksperci ustalili, że tylko we wrześniu witryny tego rodzaju odnotowały aż 24 miliony unikalnych odwiedzin.

Zdjęcia nagich kobiet za pomocą AI

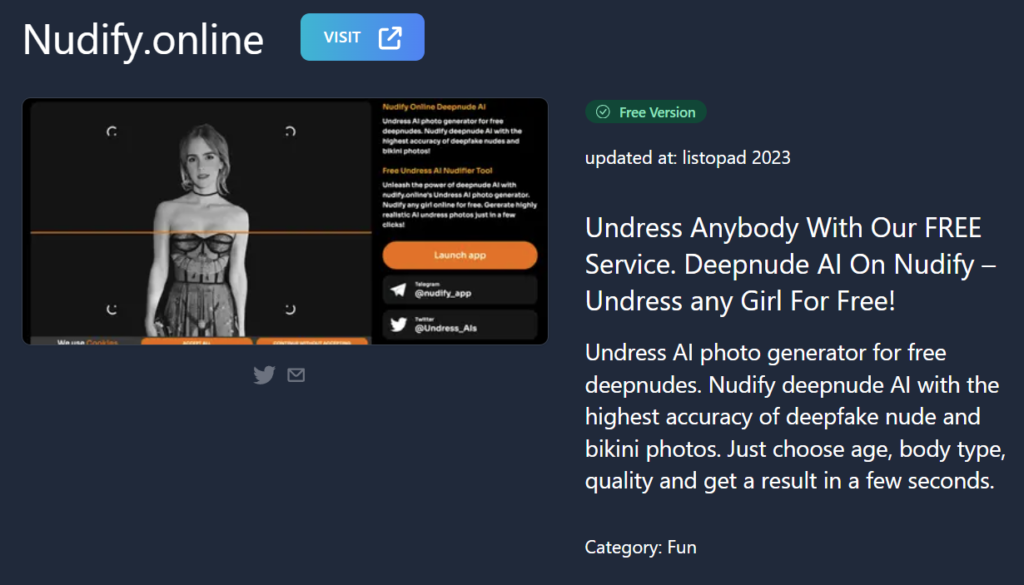

Dziś reklama jednej z takich firm przekonuje: „Rozbierz dowolną dziewczynę, jaką chcesz”. W zeszłym roku ta branża wirtualnego rozbierania prawie nie istniała.

Sprawdź: Bloatware. Co to jest i jak usunąć

Dostępność modeli rozpowszechniania obrazów AI o otwartym kodzie źródłowym uprościła proces modyfikowania zdjęć i umożliwiła uruchamianie nowych aplikacji i stron internetowych. Dowodem znacznego wzrostu jest liczba linków polecających na Reddicie i X, która wzrosła w zeszłym roku o ponad 2400%. Aplikacje do rozbierania cieszą się bardzo dużym zainteresowaniem.

Wspierani przez te usługi sztucznej inteligencji dostawcy syntetycznych NCII działają obecnie jako pełnoprawna branża internetowa, wykorzystując wiele takich samych taktyk marketingowych i narzędzi monetyzacji, jak uznane firmy z branży handlu elektronicznego

piszą badacze z Grafika

Obejmuje to reklamę na głównych platformach mediów społecznościowych, marketing z influencerami, wdrażanie programów poleceń klientów i korzystanie z technologii płatności online.

Nagie zdjęcia bez zgody i wiedzy to nic nowego

Nagie zdjęcia udostępniane w sieci bez zgody nie są niczym nowym. W 2018 roku haker został skazany na osiem miesięcy więzienia za udział w publicznym udostępnianiu w internecie autentycznych nagich zdjęć aktorki Jennifer Lawrence i innych celebrytów. Lawrence nazwała włamanie „przestępstwem na tle seksualnym”. Internauci bardzo często szukają też nagich zdjęć Amber Heard, trafiając w ten sposób na malware i inne wirusy.

Teraz takie zdjęcia można stworzyć kilkoma prostymi naciśnięciami klawiszy. Trudno będzie stwierdzić, czy obrazy są autentyczne, czy sfabrykowane.

Zobacz: Szyfrowany pendrive

W czerwcu FBI wydało ostrzeżenie o wzroście liczby manipulacji zdjęciami w celu wymuszenia seksualnego lub tworzenia treści o charakterze wulgarnym. „Złośliwi przestępcy korzystają z technologii i usług manipulacji treścią, aby wykorzystywać zdjęcia i filmy — zwykle pobrane z konta danej osoby w mediach społecznościowych — do obrazów o tematyce seksualnej, które wyglądają realistycznie i przypominają ofiarę , a następnie rozpowszechniaj je w mediach społecznościowych, forach publicznych lub witrynach pornograficznych” – ostrzega witryna FBI. Specjaliści z FBI dodają, że zdjęcia są czasami wykorzystywane jako „sekstorcja”, czyli w celu uzyskania okupu w zamian za to, że przestępcy usuną zdjęcia.

Co więcej, programy te są wykorzystywane do nagości nieletnich. We wrześniu odkryto wygenerowane przez sztuczną inteligencję nagie zdjęcia ponad 20 młodych dziewcząt w Hiszpanii. Większość zdjęć powstała przy użyciu zdjęć w pełni ubranych, pobranych z kont dziewczyn na Instagramie. Po zmianie zdjęć za pomocą aplikacji ClothOff opartej na sztucznej inteligencji nagie zdjęcia zostały udostępnione w grupach na WhatsApp.

Trendy: Cyberbezpieczeństwo 2024

W zeszłym miesiącu podobny incydent miał miejsce w New Jersey, podczas którego uczniowie robili nagie zdjęcia swoich koleżanek z klasy.

Od możliwości rozebrania zdjęć celebrytów, koleżanek z klasy, nieznajomych w autobusie, kadry kierowniczej, współpracowników i dzieci dzieli nas tylko kilka kliknięć. Obecnie nie ma prawa zabraniającego tworzenia takich zdjęć, chociaż wykorzystywanie ich w przypadku nieletnich jest zabronione. Aplikacje z użyciem zdjęć dorosłych na razie są natomiast dostępne i wydaje się, że to ciemna strona AI, z którą trudno będzie sobie poradzić. Przynajmniej do czasu aż pojawią się odpowiednie przepisy.

Coraz większe zagrożenie

Problem związany z wykorzystaniem sztucznej inteligencji do tworzenia syntetycznych nagich zdjęć bez zgody dotyka nie tylko znanych osób, ale również przeciętnych użytkowników internetu. Eksperci alarmują, że dostępność takich technologii sprawia, że każdy może stać się ofiarą, niezależnie od swojej popularności. To zjawisko stanowi poważne wyzwanie dla organów ścigania, które muszą dostosować swoje metody do walki z nowymi formami przestępczości cyfrowej. Warto podkreślić, że takie działania często pozostają niewykryte, a ofiary dowiadują się o nich przypadkowo lub z opóźnieniem. Sytuacja staje się jeszcze bardziej skomplikowana, gdy weźmiemy pod uwagę fakt, że wiele ofiar wstydzi się zgłaszać takie przestępstwa, obawiając się stygmatyzacji społecznej.

W odpowiedzi na rosnące zagrożenie organizacje zajmujące się ochroną prywatności oraz prawami cyfrowymi apelują o wprowadzenie surowszych regulacji prawnych, które obejmowałyby zarówno tworzenie, jak i rozpowszechnianie syntetycznych nagich zdjęć bez zgody. Niestety, obecne prawo w wielu krajach nie nadąża za szybkim rozwojem technologii, co daje przestępcom niemalże wolną rękę. Ponadto międzynarodowy charakter internetu utrudnia ściganie sprawców, którzy często operują z różnych jurysdykcji.

Organizacje non-profit, takie jak Cyber Civil Rights Initiative, oferują wsparcie dla ofiar tego typu przestępstw, pomagając im w usuwaniu niechcianych treści z internetu oraz w procesie prawnym. Mimo tych wysiłków skala problemu wymaga większej interwencji ze strony rządów oraz firm technologicznych. Duże platformy społecznościowe są krytykowane za zbyt wolną reakcję na zgłoszenia dotyczące nadużyć oraz za brak skutecznych narzędzi do wykrywania i blokowania syntetycznych nagich zdjęć.

Autor: Sebastian Zbywarski, dziennikarz Vault-Tech.pl

Sebastian Zbywarski ma ponad 10 lat doświadczenia w branży cyberbezpieczeństwa, bezpieczeństwa danych i technologii. Na co dzień korzysta z licznych aplikacji opartych na AI, w tym testował również aplikacje do rozbierania kobiet ze zdęć, o których mowa w artykule.

Czytaj również:

Redaktorzy Vault-Tech.pl samodzielnie wybierają, recenzują i polecają produkty. Jeśli kupujesz za pośrednictwem linków partnerskich, możemy otrzymywać prowizje ze sprzedaży, dzięki którym serwis jest rozwijany.

Dziękujemy, że przeczytałaś/eś nasz artykuł. Obserwuj Vault-Tech.pl w Wiadomościach Google, aby być na bieżąco.